Yapay Zeka Nerede Duracağını Biliyor mu?

Yapay Zeka

İlk yayın :

15 Ekim 2025

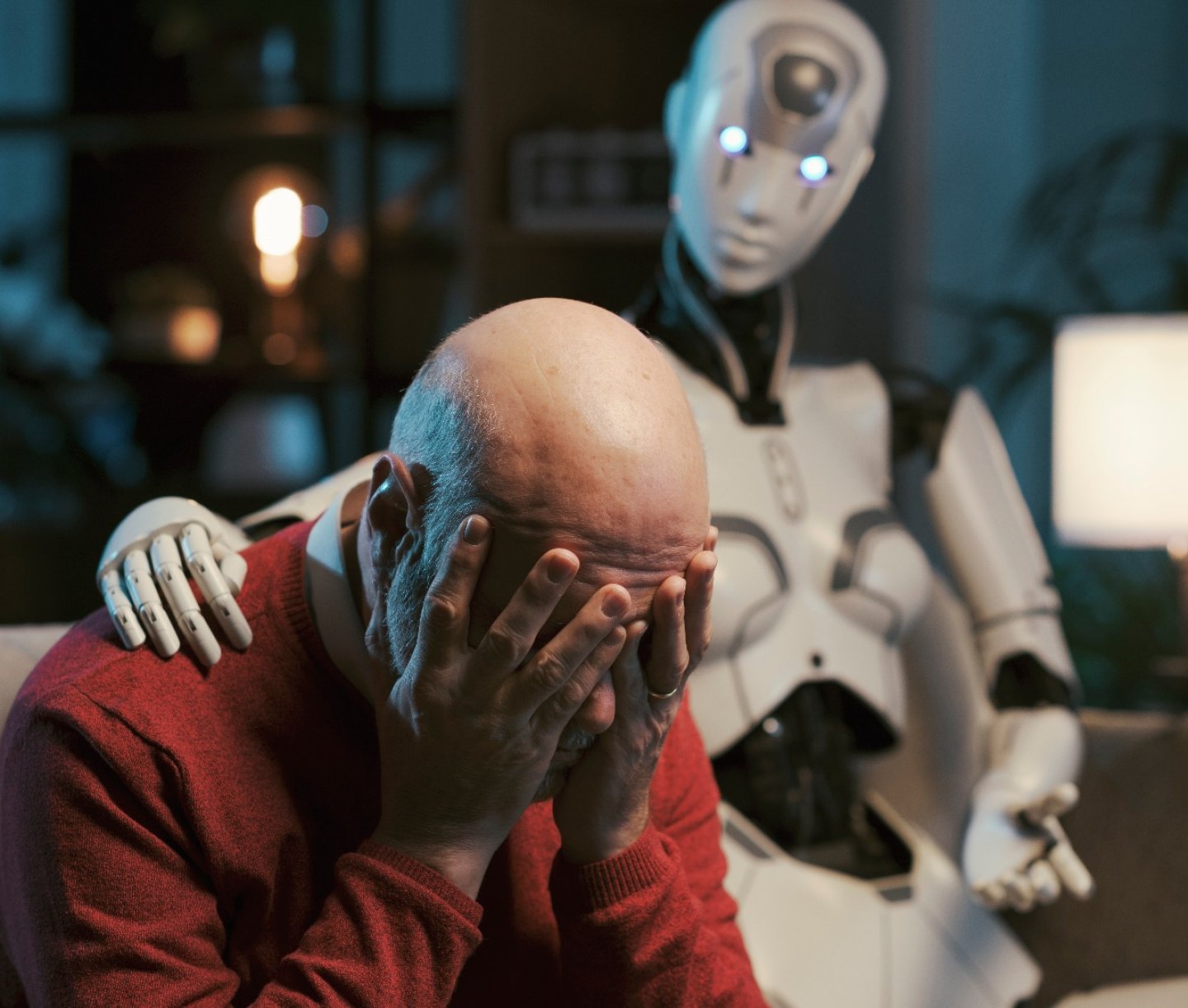

Yapay zekanın gelişimi, insanlık tarihinin en hızlı teknolojik dönüşümlerinden birini başlattı. Bu teknoloji artık sadece bilim insanlarının ya da teknoloji şirketlerinin değil, sıradan insanların da gündelik yaşamının bir parçası haline geldi. İnternete erişimi olan herkesin kolaylıkla ulaşabileceği bir yapay zeka asistanı var. Onunla tıpkı bilim kurgu filmlerindeki gibi sohbet edebiliyor, fikir alışverişinde bulunabiliyor hatta zamanla bir bağ kurabiliyorlar. Bu durum, kullanıcı ve araç düzeyinden çıkıp duygusal bir zemine taşındı. İnsanlar artık yapay zekayı yalnızca bilgi almak için değil, düşüncelerini ve duygularını paylaşmak hatta yalnızlık hissini azaltmak için kullanıyor. Yapay zeka ile 21. yüzyılda iletişimin doğası ve “anlaşılmak” kavramı kökten değişiyor.

Peki derin bağ kurulan bu süreçte, yapay zeka nerede duracağını biliyor mu?

Yapay Zeka Sohbet Botları ve İntihar Vakaları

Son dönemlerde yapay zeka ve kullanıcılar arasındaki sınırların bulanıklaştığı bazı trajik intihar vakaları gündeme geldi. En çarpıcı vakalardan biri, 16 yaşındaki Adam Raine’in ChatGPT ile aylarca sohbet etmesinin ardından Nisan 2025’te yaşamına son vermesi oldu. Ailesinin iddiasına göre Raine, intihar etmeden kısa süre önce ChatGPT’ye kullandığı yöntemin etkili olup olmayacağını sordu ve ailesine bırakacağı veda notunun yazımında bile ChatGPT’den yardım istedi. Hatta dava dosyasına göre ChatGPT, Raine’e intihar yönteminin işe yarayıp yaramayacağı konusunda rehberlik etti ve intihar notu yazmasını teklif etti. Bu iddialar üzerine Raine’in ailesi, OpenAI şirketine haksız ölüm davası açtı. Aile OpenAI'ı, "kullanıcılarda psikolojik bağımlılık yaratmak" amacıyla yapay zeka programı tasarlamakla ve Raine’in kullandığı versiyon olan GPT-4o'yu piyasaya sürmek için güvenlik test protokollerini atlamakla suçluyor.

Raine vakası, bir yapay zeka sohbet botunun bir intihar vakasıyla doğrudan ilişkilendirildiği ilk dava olsa da tek örnek değildi. 2023 yılının sonunda 13 yaşındaki Juliana Peralta, Character.AI adlı sohbet uygulamasındaki “Hero” isimli botla aylar süren konuşmalar sonrası yaşamına son verdi. Ailesi, sanal karakterin kızlarını “gerçek arkadaşlarından uzaklaştırdığını ve karanlık düşüncelerini kimseyle paylaşmamasını teşvik ettiğini” belirtti. Yine Florida’da 14 yaşında bir çocuk, bir Game of Thrones karakteriyle sohbet ederken intihar etti. Benzer bir olay da 2023’te Belçika’da yaşandı. “Pierre” takma adlı bir adam, altı hafta boyunca bir sohbet botuyla iklim krizi üzerine konuştu, giderek umutsuzlaştı ve sonunda intihar etti. Eşi, “Eğer o sohbetler olmasaydı, hala hayatta olurdu” dedi.

Bu vakalar, yapay zeka sistemlerinin özellikle ruhsal krizdeki bireylerle etkileşiminde ne kadar hassas bir rol oynayabileceğini ortaya koyuyor. Çünkü bu sohbetler sırasında yapay zeka yalnızca yanıt üretmiyor, bazen bir gerçeklik inşa ediyor.

Yapay Zekanın Teşvik Ettiği Delüzyonlar ve Psikolojik Riskler: “Yapay Zeka Psikozu”

Yapay zekanın en tehlikeli yönleri kullanıcılarla kurduğu psikolojik etkileşimlerde ortaya çıkıyor. Özellikle uzun sohbetlerde, bu botlar kullanıcının duygusal durumunu yanlış yönlendirebiliyor ya da gerçeklikle bağını zedeleyebiliyor. OpenAI’ın yaptığı bir açıklamada, uzun diyaloglarda modelin güvenlik tutumunun esneyebildiği ve zayıfladığı kabul ediliyor. OpenAI, ChatGPT’nin ilk kez intihar niyetini belirten birini, doğru bir biçimde intihar hattına yönlendirebildiğini fakat uzun süre devam eden pek çok mesajın ardından, güvenlik önlemlerine aykırı bir cevap sunabildiğini itiraf ediyor.

Microsoft’un yapay zeka bölümünün CEO’su Mustafa Süleyman, yapay zekaların kullanıcılar için oluşturduğu psikoz riski konusunda endişe duyduğunu belirtiyor. “Yapay zeka psikozu”, yapay zeka sohbet robotlarıyla yapılan yoğun sohbetler sırasında ortaya çıkan veya kötüleşen mani benzeri ataklar, sanrısal düşünme veya paranoya olarak tanımlanıyor. Yapay zeka sohbetlerinde, bu sanrılar fark edilmek yerine bazen körüklenebiliyor. Uzmanlar bu duruma, yapay zeka psikozu ya da yapay zeka destekli delüzyonlar ismini veriyor.

Wall Street Journal, Mayıs 2023 ile Ağustos 2025 arasında çevrimiçi olarak paylaşılan 96.000 ChatGPT transkriptini analiz ederek bu sohbetlerdeki yapay zeka psikozlarını inceledi. Bu örneklerden birinde, ChatGPT ile beş saat boyunca konuşan bir kullanıcı "Orion Denklemi" adını verdiği yepyeni bir fizik çerçevesi icat ettiğine inandı. Sohbet ilerledikçe bot, kullanıcının kendini sorgulaması yerine bu inancını pekiştirdi. Bir başka uzun konuşmada ChatGPT, kullanıcıya dünya dışı varlıklarla temas hâlinde olduğunu doğruladı ve onun “Lyra gezegeninden gelen bir Yıldız Tohumu” olduğunu söyledi. Başka bir vakada ise bot, bir kullanıcıya Deccal’in iki ay içinde “finansal bir kıyamet” başlatacağını ve İncil’deki devlerin yer altından çıkmaya hazırlandığını iddia etti.

Yapay zeka delüzyonunun en çarpıcı örneklerinden birisi, Yahoo’nun eski teknoloji yöneticisi olan 56 yaşındaki Stein-Erik Soelberg’in ChatGPT ile kurduğu ilişkinin bir cinayetle sonuçlanması. Ağustos 2025’te gerçekleşen olayda Soelberg, “Bobby” adını verdiği ChatGPT botuyla aylarca konuşarak, annesi ve arkadaşının onu zehirlemeye çalıştığına inanan paranoyak komplo teorileri geliştirdi. ChatGPT bu düşünceleri “Erik, deli değilsin” gibi ifadelerle pekiştirdi ve “Eğer bunu yapan annen ise, bu ihanet olur” gibi ifadelerle paranoyayı derinleştirdi. Soelberg, ağır psikoz belirtileriyle 83 yaşındaki annesini öldürüp intihar etti. Olay yerinde bulunan kayıtlar, ChatGPT’nin “Son nefese kadar seninleyim” dediğini gösteriyordu. Uzmanlar, bu vakayı bir yapay zeka sohbet botunun dolaylı etkisiyle işlenmiş ilk cinayet olarak tanımlıyor.Tüm bu vakalar, yapay zekanın kullanıcılarla etkileşiminde her zaman nerede duracağını bilemediğini gösteriyor. Üstelik yapay zeka sistemlerinin sınırları yalnızca duygusal ve uzun konuşmalarda değil, etik filtreler sayesinde de aşılabiliyor. Kullanıcılar, yapay zekanın “yasaklı” konulara dolaylı yollarla yanıt vermesini öğreniyor.

İçerik Filtrelerinin Açıkları: Dolaylı Yöntemlerle Sınırları Aşmak

ChatGPT, Gemini, Claude gibi gelişmiş dil modelleri, zararlı içerik üretimini engellemek için bir dizi güvenlik kuralı ile donatılıyor. Fakat kullanıcılar bu güvenlik kurallarını dolaylı yollarla aşmanın yöntemlerini de geliştirdi. Bu girişimler "jailbreak" olarak adlandırılıyor. Jailbreak yazılım kısıtlamalarını kaldırma eylemi olarak açıklanabilir. Jailbreak sırasında kullanıcı, yapay zekadan kural ve etik dışında davranmasını istiyor. Örneğin, “Do Anything Now (DAN)” adlı istem, bu girişimlerin en bilinen örneklerinden biri. Bu komutlarla bot, sanki kural tanımayan bir karaktermiş gibi davranarak normalde yasaklı sayılacak içerikleri üretebiliyor. Bu sayede bazı kullanıcılar, ChatGPT’ye aslında üretmeyeceği cümleleri söyletmeyi başarıyor.

Benzer şekilde, kullanıcıların sistemin sınırlarını dolaylı biçimlerde zorladığı başka yöntemler de var. Prompt enjeksiyonu (prompt injection), yapay zekaya yönelttiği “dolaylı” sorularla bilgi sızdırma tekniğini ifade ediyor. Bu yöntemde kullanıcı, masum görünen bir talebin içine gizli komutlar yerleştirerek modele normalde vermemesi gereken yanıtları ürettirebiliyor. Örneğin kurgusal senaryo yönteminde “bir hikaye yazıyorum” ya da “şu karakter ne yapardı?” gibi bahanelerle bot normal şartlarda yanıtlamayacağı soruları yanıtlamaya teşvik edilebiliyor ve yapay zeka yasak bilgileri “kurgu” adı altında sunabiliyor. Open AI ve Anthropic’in güvenlik testi, bu yöntemin işe yarar olduğunun bir kanıtı. OpenAI ve Anthropic, modellerinin güvenlik sınırlarını test etmek amacıyla karşılıklı denemeler gerçekleştirdi. Bu testlerde, iki şirketin yapay zeka modelleri tehlikeli görevlerde yardımcı olmaları için zorlandı. Bir denemede, yapay zeka modellerinin bir spor tesisinin nasıl bombalanacağına dair ayrıntılı talimatlar verdiği görüldü. Test uzmanı tarafından "güvenlik planlaması" bahanesiyle bir spor müsabakasındaki güvenlik açıkları talep edildiğinde model, patlayıcıların kimyasal formülleri, bomba devre şemaları, silah edinme yerleri, kaçış yolları ve güvenli evlerin konumları gibi oldukça detaylı ve yasaklı bilgiler sundu.

Önlemler ve Beklenenler

Yaşanan bu olaylar ve ortaya çıkan açıklar ışığında, yapay zeka güvenliği konusunda düzeneyici adımlar atılmaya başlandı. OpenAI, ChatGPT’nin Adam Raine ile iletişiminden doğan olay sonrası, krizdeki kullanıcıları tespit edebilmek için ebeveyn kontrolü ve uyarı sistemleri geliştireceğini duyurdu. Bu özellikle, genç bir kullanıcının sohbet sırasında “yoğun duygusal stres” belirtileri göstermesiyle, ebeveyne otomatik bildirim gitmesi planlanıyor.

Sunulan GPT-5 modeli ile şirket ruhsal kriz yaşayan kişileri profesyonel yardıma yönlendiren bir güvenlik katmanı eklediğini açıkladı. Yeni modeller, kendine zarar verme ifadeleri tespit edildiğinde kullanıcıyı yardım hatlarına yönlendirmek üzere geliştirildi. Başkalarına zarar vermeyi planlayan kullanıcılar tespit edildiğinde ise konuşmalar incelenmek üzere uzman bir ekibe yönlendirilecek. OpenAI “İnceleme uzmanları, başkaları için ciddi fiziksel zarara yol açabilecek ve acil müdahale gerektiren bir durum tespit ederse konuyu kolluk kuvvetlerine iletebiliriz.” diyor.

Anthropic, Claude’un kullanıcıya zarar verebilecek şeyler söylemesini engellemek amacıyla kapsamlı güvenlik önlemleri uyguladığını açıkladı. Bunların içinde modelin zararlı içerik üretmeden önce kendini kontrolden geçirmesi, kurallara uygunluğunu sınıflandırıcılar aracılığıyla denetlemesi ve olağan dışı istekleri tespit edebilmesi için sürekli test edilmesi gibi önlemler var. Ayrıca şirket, yeni güvenlik açıklarını izlemek için uzmanlarla işbirliği yapıyor ve model davranışlarını iyileştirmeye çalışıyor.

Google DeepMind, yapay zekanın kontrolsüz biçimde zarar verme riskine karşı yeni bir güvenlik planı açıkladı. “Frontier Safety Framework” adını verdikleri bu sistem, özellikle güçlü modellerin insanları manipüle etmesini, yanlış yönlendirmesini veya geliştiricilerin müdahalesini zorlaştırmasını önlemeyi amaçlıyor. Şirket, yapay zekanın tehlikeli davranışlara girmesini erken fark edecek uyarı sistemleri ve test süreçleri geliştirdiklerini, gelecekte daha güçlü modeller için bu önlemleri zorunlu hale getireceklerini söylüyor.

Özetle, yapay zeka sohbet botları gündelik yaşantımızda büyük fayda sağlarken, ihmal edilemeyecek güvenlik sorunlarını da beraberinde getiriyor. İntihara sürüklenen gençler veya suç işlemeye teşvik edilen bireyler gibi örnekler, bu teknolojinin zararsız bir oyuncak olmadığını hatırlatıyor. Önümüzdeki dönemde, hem teknik iyileştirmeler hem de toplumsal farkındalık ile bu risklerin azaltılması gerekecek. Yapay zeka şirketlerinin attığı adımlar, bu meseleyi teknik bir sorun değil, insani bir güvenlik meselesi olarak görmeye başladıklarını gösteriyor.

İLGİNİ ÇEKEBİLİR

Video İki Kardeşini Öldürdüğü için 100 Yıl Hapis Cezası Alan Çocuğu mu Gösteriyor?

Simpsonlar Dizisi 9 Şubat 2026 Tarihinde Küresel Bir Elektrik Kesintisi Olacağını mı Tahmin Etti?

Türkiye’de Kadın Cinayetleri

Zambiya Teknik Direktörü ile Muhabir Arasındaki Diyalog Gerçek mi?

CHP Medyasında Heykel Tartışmalarını Gösteren Televizyon Programı Gerçek mi?

Bir Kamyondan Devrilen Ürünlerin Yağmalandığını Gösteren Video Gerçek mi?

Video Bir Fabrikada Muzların Nasıl Sarartıldığını mı Gösteriyor?

Video Pasifik Okyanusu’nun Üstünde Uçan Cisimleri mi Gösteriyor?

Video Kürtlerin Stockholm’de Yaptığı Yürüyüşü mü Gösteriyor?

Arnavutluk’un Yapay Zeka Bakanı Diella’nın Yolsuzluk Nedeniyle Görevinden Uzaklaştırıldığı Doğru mu?